Am ITAW haben wir begonnen, Computer Vision und künstliche Intelligenz einzusetzen, mit dem Ziel, die Biologie und Ökologie von Wildtieren zu erforschen.

Dank der Entwicklung und Verbreitung von Technologien wie Kamerafallen, videofähigen Tags oder akustischen Sensoren haben Ökologen heute Zugang zu immensen Datenmengen in Form von Bildern, Videos und Aufzeichnungen. Die mit diesen Methoden gesammelten Daten lassen sich nur schwer manuell auswerten, da sie in freier Wildbahn unter höchst unterschiedlichen Bedingungen gesammelt werden, was die Entwicklung von Protokollen, die für jeden Fall geeignet sind, zu einer Herausforderung macht.

Ein zweiter Aspekt, der die Analyse erschwert, ist der schiere Umfang der Daten. Eine einzige Kamerafalle kann innerhalb weniger Tage Tausende von Bildern aufnehmen, während videofähige Sender Gigabytes an Videomaterial aufzeichnen können, bevor sie sich vom Tier lösen, um wiedergefunden zu werden. Die manuelle Durchsicht solcher Daten erfordert von den Forschern viel Zeit und Mühe. Ein großer Teil besteht darin, die nützlichen Bilder/Videos/Aufzeichnungen von den unbrauchbaren zu trennen. Kamerafallen werden beispielsweise in der Regel durch Bewegung aktiviert, was dazu führen kann, dass viele “leere” Bilder aufgenommen werden, wenn sich die Kamera in der Nähe von sich bewegendem Gras oder einem Gewässer befindet.

Computer-Vision-Techniken und künstliche Intelligenz können den Forschern helfen, indem sie die Arbeit des Aussiebens der Daten dem Computer überlassen.

Computer Vision

Unter Computer Vision versteht man eine Reihe von Techniken und Algorithmen, die es Computern ermöglichen, visuelle Informationen zu interpretieren und zu erfassen. Im ITAW setzen wir derzeit Computer Vision im Rahmen unserer Robbenforschung ein.

Computer Vision für Robben-Videotags

Um das Wissen über die Ökologie der Seehunde in der Nordsee zu erweitern, hat das ITAW-Team Kameras an Wildtieren angebracht. Ziel ist es, damit Raubtiere zu erfassen, um verschiedene Aspekte der Ökologie der Robben bei der Nahrungssuche zu verstehen. Darüber hinaus werden diese Beobachtungen auch dazu beitragen, die mit nicht videofähigen Tags gewonnenen Daten zu validieren, da bei dieser Art von Tags die Raubtierereignisse von Messungen der Tiefe sowie der Geschwindigkeit- und Richtungsänderungen als Proxy abgeleitet werden.

Um die Tausenden von aufgezeichneten Videos zu sichten, haben wir eine Bildverarbeitungspipeline entwickelt, die relevante Informationen über die Videodateien zusammenfasst, wie z. B. die vorherrschende Farbe pro Einzelbild, wodurch Videos mit einem hohen Anteil an schwarzen oder sehr dunklen Einzelbildern ausgeschlossen werden können. Darüber hinaus extrahieren wir auch Merkmale jedes Einzelbildes wie die Entropie oder die Differenz zwischen den Einzelbildern. Dies ermöglicht es uns, Teile des Videos zu erkennen, in denen es starke Veränderungen zwischen den Einzelbildern gibt, was unseren Forschern hilft, mögliche Raubvorkommnisse zu erkennen, ohne alle Videos durchgehen zu müssen.

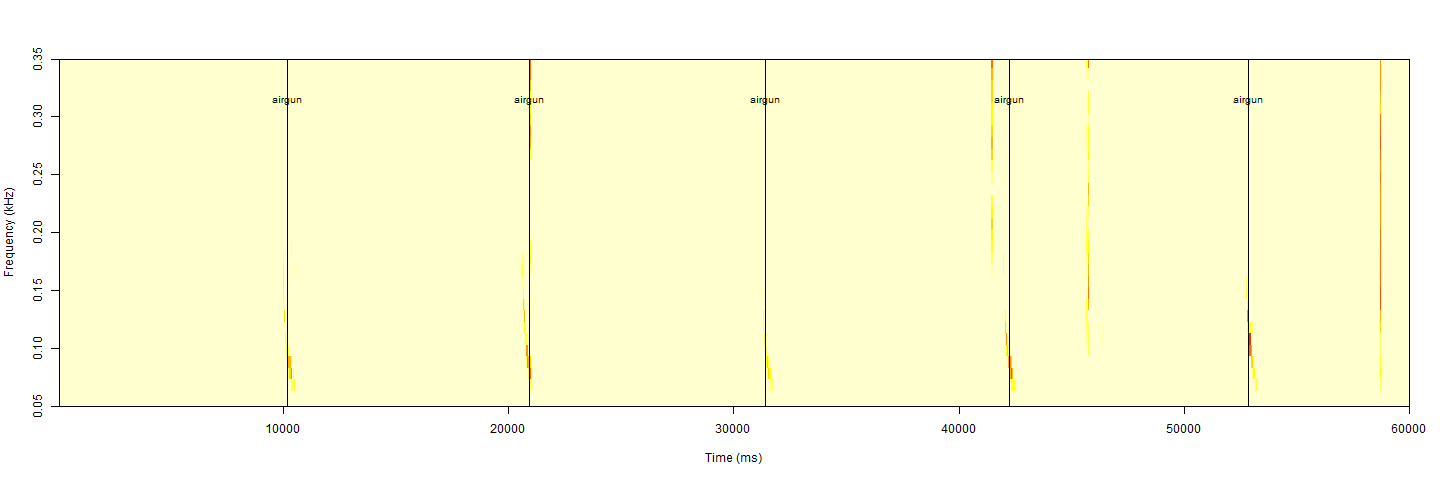

Beispiel für die Verwendung von Entropie-Änderungen zwischen Einzelbildern zur Erkennung von Teilen mit starker Bewegung in den Videos; die Spitzen zeigen Teile des Videos an, in denen es starke Änderungen zwischen Einzelbildern gibt. Dies kann zur Erkennung von Raubtierereignissen verwendet werden

Künstliche Intelligenz

Das zuvor gezeigte Beispiel beruht auf der Verwendung von Bildanalysetechniken ohne den Einsatz künstlicher Intelligenz. Heutzutage bezieht sich der Begriff künstliche Intelligenz im Allgemeinen auf die Verwendung von Deep-Learning-Modellen, die bei der Analyse komplexer Daten helfen. Um dies zu erreichen, müssen die Modelle auf korrekt gekennzeichneten Daten trainiert werden, was in der Regel große Datenmengen und Rechenleistung erfordert.

Bei jeder Iteration des Trainingsprozesses werden die Gewichtungen des Modells aktualisiert, um die Differenz zwischen den beobachteten und den vorhergesagten Ergebnissen zu verringern. Deep-Learning-Modelle bestehen aus Millionen von Knoten, von denen jeder seine eigene Gewichtung hat. Durch die dichte Verknüpfung dieser Knoten kann das Netzwerk lernen, sehr komplizierte Muster zu erkennen. Die Eigenschaften dieser Knoten und die Art und Weise, wie sie miteinander verbunden sind, werden als "Architektur" des Modells bezeichnet und können einen großen Einfluss auf die Leistung des Modells und die Aufgaben, die es erfüllen kann, haben.

Im ITAW setzen wir derzeit Modelle der künstlichen Intelligenz für drei unserer Projekte ein: Erkennung von Robben in Aufnahmen aus der Luft, Erkennung von Ottern in Kamerafallen und passiv akustisches Monitoring von Walen in der Nordsee. Derzeit trainieren wir die Modelle von Grund auf, um Bilder mit Siegeln von solchen ohne Siegel zu unterscheiden. Letztendlich sollen die Modelle auch beim Zählen helfen. Diese Aufgabe stellt jedoch eine zusätzliche Herausforderung dar, da sie die Identifizierung von Arten erfordert, was sie komplexer macht.

Einsatz von Megadetector zur Unterstützung der Otterforschung

Modelle der künstlichen Intelligenz haben den zusätzlichen Vorteil, dass sie modular und wiederverwendbar sind. Sobald die Modelle trainiert wurden, können die Gewichtungen der Öffentlichkeit zugänglich gemacht werden, und jeder kann das Modell auf seinen eigenen Daten laufen lassen. Megadetector ist ein YOLOv5-Modell (You Only Look Once), ein Computer Vision Modell mit Echtzeit-Objekterkennungsfunktionen, das auf Millionen von Kamerafallenbildern von Wildtieren aus der ganzen Welt trainiert wurde. Derzeit nutzen wir die Standardgewichtungen von Megadetector, um die Bilder von Kamerafallen schnell auf das Vorhandensein von Tieren zu analysieren. Diese Bilder werden dann von einem Spezialistenteam untersucht, um unsere Zielart, den Fischotter, zu finden. Wir ziehen jedoch auch eine Feinabstimmung des Modells in Betracht. Bei der Feinabstimmung werden die vorab trainierten Modellparameter so angepasst, dass sie für bestimmte Aufgaben oder Datensätze besser geeignet sind, um die Leistung zu verbessern. Dieser Prozess ermöglicht es uns, die Genauigkeit von Megadetector für die Überwachung von Wildtieren zu optimieren und so wirksame Schutzmaßnahmen zu gewährleisten. Der derzeitige Vorteil des Megadetectors ist seine Geschwindigkeit, die es uns ermöglicht, Millionen von Bildern innerhalb weniger Stunden durchzugehen.

R-Paket 'soundClass' und Minkedetektor zur Erkennung potenzieller Zwergwalvokalisationen

KI wird auch für das passiv akustische Monitoring (PAM) eingesetzt, das es ermöglicht, Daten aus der Meeresumwelt über lange Zeiträume hinweg aufzuzeichnen. Die Fortschritte bei der Datenerfassung, -speicherung und -verarbeitung sowie Batteriekapazität machen den Einsatz von Machine-Learning zur Erkennung akustischer Signale unumgänglich. Im Rahmen des Projekts HABITATWal wird eine akustische Untersuchung zur Aufzeichnung von Zwergwalvokalisationen an der Doggerbank in der deutschen Nordsee durchgeführt. Die riesige Menge an Daten, die bei Langzeitaufzeichnungen gewonnen wird, ist mit einem übermäßigen Zeitaufwand für das Abhören und Screening der Audiodateien verbunden. Daher setzen wir KI-Methoden ein, um dieses Problem zu lösen. Vor kurzem wurde ein neues Paket namens 'soundClass' für die Software R entwickelt, das sich mit dieser Herausforderung befasst. SoundClass basiert auf Convolutional Neural Networks (CNN), die eine robuste Erkennung und Klassifizierung von Meeresschallquellen wie Zwergwalvokalisationen oder anthropogenen Ereignissen ermöglichen.